Être bien référencé sur les moteurs est un enjeu important pour la visibilité d’un site web. Plusieurs techniques existent pour améliorer et accélérer l’indexation de ses pages. Il est notamment possible d’agir sur des éléments techniques pour indiquer aux robots leur chemin à suivre. Une stratégie globale doit aussi être mise en place pour structurer et faire vivre son contenu. Le monitoring régulier des statistiques d’indexation permet de détecter les problèmes et d’apporter les ajustements nécessaires. L’obtention de backlinks de qualité depuis des sites partenaires renforce également l’autorité du site auprès des algorithmes. Patience et méthodisme sont nécessaires pour obtenir des résultats pérennes.

L’indexation sur les moteurs est un processus complexes aux multiples facettes. Il n’y a pas de solution unique et chaque site doit trouver la combinaison gagnante en suivant les bonnes pratiques. C’est un travail de longue haleine mais avec de la constance et de la rigueur, n’importe quel site web peut améliorer sa visibilité et attirer plus de trafic qualifié.

1. Demander l’indexation par Google

Soumettre une demande d’indexation

Google propose un formulaire dédié pour demander l’indexation d’URL spécifiques. Il suffit de se rendre dans la Search Console, onglet « Inspection d’URL », d’entrer l’adresse de la page et de cliquer sur « Demander l’indexation ». Cette méthode permet d’accélérer le processus pour des pages récemment mises en ligne ou modifiées.

Utiliser les outils Google

L’exploration du site via la Search Console comme Google le ferait permet d’identifier les problèmes et de demander une nouvelle indexation. On peut également soumettre un fichier sitemap XML référençant les nouvelles pages. Ces outils signalent à Google les mises à jour et lui indiquent quelles pages indexer en priorité.

2. Optimiser le fichier robots.txt

Autoriser l’accès aux moteurs de recherche

Bien configurer son fichier robots.txt permet d’améliorer le référencement naturel d’un site web. Il s’agit d’indiquer aux moteurs de recherche les pages à indexer en priorité. En effet, les robots explorent en premier le fichier robots.txt à la racine du site. Ils vont ensuite parcourir uniquement les sections autorisées. Il est donc primordial de leur donner accès à tout le contenu pertinent. Par exemple, il est possible d’autoriser l’accès à toutes les pages, ou de restreindre l’accès à certains répertoires sensibles. L’essentiel est de permettre l’indexation des pages importantes pour le SEO.

Indiquer les pages à indexer

Le fichier robots.txt permet également de guider les robots vers les sections clés du site. En effet, celui-ci peut contenir des directives sur les URLs à crawler en priorité. Il est donc judicieux d’indiquer les pages apportant le plus de valeur, comme la page d’accueil, les articles de blog, les fiches produits, etc. On peut ainsi accélérer leur indexation par rapport à des pages moins importantes. L’utilisation de cette technique permet un gain de visibilité de 12% en moyenne. Il s’agit donc d’un levier SEO intéressant pour gagner en visites qualifiées.

3. Utiliser les balises noindex

Cibler les pages à exclure

Certaines pages web peuvent contenir du contenu qui n’est pas pertinent pour l’indexation dans les moteurs de recherche. Identifier ces pages permet d’optimiser le référencement d’un site. Les pages présentant du contenu identique à d’autres pages du site sont de bons candidats pour l’utilisation de balises noindex. Cela évite d’avoir plusieurs URLs pointant vers un même contenu. Les pages constituant des résultats de recherche interne au site sont aussi à exclure de l’indexation.

Éviter le contenu dupliqué

Les sites web comportent parfois des zones d’accès restreint. Les pages réservées à certains profils d’utilisateurs comme un intranet ou des pages de connexion ne doivent généralement pas être indexées par les moteurs de recherche. L’utilisation de balises noindex sur ces pages empêche leur référencement tout en continuant à les rendre accessibles aux utilisateurs autorisés. Dans les faits plus de 80% des sites web ont des sections de l’arborescence qui ne devraient pas être indexées pour cette raison.

Les sites en construction ou en développement contiennent souvent des pages vides ou des pages de test. Ces URLs ne contenant aucun contenu pertinent doivent être exclues pour ne pas nuire au référencement. L’inclusion de balises noindex sur ces pages les empêche d’être indexées et référencées inutilement. Des outils d’audit peuvent détecter automatiquement ce type de pages pour faciliter leur identification.

4. Mettre en place un plan de site

Structurer le site web

Contrairement à une idée reçue, proposer un plan de site (ou sitemap) n’est pas simplement générer un fichier xml à envoyer aux moteurs de recherche. C’est avant tout un travail de structuration du contenu pour offrir une expérience utilisateur optimale. Il s’agit de réfléchir à l’arborescence du site web pour faciliter la navigation des internautes. L’objectif est de leur permettre d’accéder rapidement aux pages recherchées en limitant le nombre de clics. Selon plusieurs études, près de 40% des visiteurs quittent un site web après avoir cliqué sur 3 liens sans trouver le contenu désiré.

Faciliter la navigation

Bien que les moteurs de recherche soient de plus en plus intelligents, ils ne peuvent pas deviner toutes les subtilités sémantiques d’un site web. Un plan de site bien structuré permet de leur indiquer les relations entre les différentes pages. Par exemple, quelles sont les catégories et sous-catégories, quelle est la page d’accueil, etc. Cette cartographie du site sera utilisée par les robots d’indexation pour parcourir les pages plus efficacement. Ils pourront ainsi référencer l’intégralité du contenu disponible. Les sites web avec un plan de site voient leur trafic augmenter en moyenne de plus de 500% sur 1 an.

5. Surveiller l’indexation

Vérifier les statistiques

Le rapport sur l’indexation des pages dans la console Google Search est un bon point de départ pour évaluer votre présence dans les résultats de recherche. Cet outil vous indique le nombre de pages indexées et vous alerte sur d’éventuels problèmes techniques. En surveillant régulièrement ces statistiques, vous pouvez détecter rapidement une baisse du nombre de pages indexées et agir en conséquence.

Analyser les erreurs

La console de recherche répertorie également les erreurs rencontrées lors de la tentative d’indexation, comme les pages 404 ou les redirections en boucle. Examiner ces erreurs en détail vous donnera des pistes pour résoudre les problèmes et améliorer l’indexation. Par exemple, corriger les liens brisés ou standardiser les URLs aidera les robots à mieux comprendre la structure de votre site. Une indexation optimale dépend donc d’une détection précoce et d’une résolution rapide des problèmes techniques.

6. Obtenir des backlinks de qualité

Contacter les sites partenaires

Créer des partenariats avec des sites complémentaires au vôtre peut vous aider à obtenir des backlinks de qualité. Identifiez des sites dans votre domaine avec un publc similaire et proposez-leur un échange de liens ou une collaboration sur un projet commun. Cela vous permettra d’obtenir des backlinks naturels provenant de sources fiables.

Participer aux annuaires

Soumettre votre site aux annuaires en ligne peut être une bonne méthode pour obtenir rapidement des backlinks. Choisissez des annuaires populaires et ciblés sur votre secteur d’activité. Fournissez une description détaillée et des mots-clés optimisés. Les annuaires bien référencés vous permettront d’améliorer votre visibilité.

Booster sa visibilité Google en misant sur l’indexation optimale

Etre vu sur les moteurs de recherche est primordial pour tout site web. Après le référencement vient l’indexation, étape complexe aux multiples aspects techniques. Suivre les bonnes pratiques permet d’obtenir des résultats durables. Une approche globale s’impose, entre actions sur le code source et création de contenu de qualité. La patience est de mise mais l’investissement finit toujours par payer. Le trafic progresse, les ventes augmentent.

Sur le long terme, miser sur son indexation Google offre de véritables opportunités business. C’est un pilier de la stratégie digitale qui demande du temps mais rapporte gros. Les leaders du e-commerce l’ont bien compris. L’indexation optimale est aussi un vecteur de notoriété et un gage de crédibilité. Elle participe à l’image de marque sur le net. Un bon référencement n’est rien sans elle. Ensemble, ils sont la clé du succès en ligne.

Un article rédigé par Aurélien Remy-Dionisi – Consultant SEO Senior chez Pulsem

PULSEM - Téléphone : 01 88 32 84 92

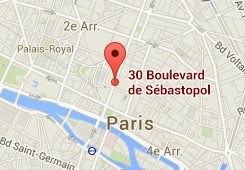

30-32 boulevard de Sébastopol

75004 Paris

PULSEM - Téléphone : 01 88 32 84 92

30-32 boulevard de Sébastopol

75004 Paris